La Inteligencia artificial y el efecto Toy Story

Nuestras tribulaciones éticas casi siempre remiten a problemas ontológicos más de fondo. Sin afrontar estos últimos, el debate ético se vuelve pura lucha de poder almibarada en buenismo. Veamos qué cuestiones ontológicas se esconden tras la polvareda ética que está levantando últimamente la llamada inteligencia artificial (IA). Y Lo más elemental que podemos preguntarnos en clave ontológica es si la IA existe. Luc Julia, quien dirigió el equipo de desarrollo de SIRI en Apple, titula un libro reciente de manera provocadora: L’intelligence artificielle n’existe pas[1]. Por su parte, Elik J. Larson está en vías de publicar un libro, en parecida línea, titulado The Myth of Artificial Intelligence Why Computers Can’t Think the Way We Do. En el avance del libro podemos leer:

“Inductive AI will continue to improve at narrow tasks, but if we want to make real progress, we will need to start by more fully appreciating the only true intelligence we know—our own”.

Un nombre inapropiado

El término Inteligencia Artificial resulta confuso

Habría que proponer, pues, una denominación mejor, que no condujese a confusión.

El término inteligencia artificial –recuerda Katharina Zweig, del Laboratorio de Responsabilidad Algorítmica de la Universidad de Kaiserslautern- surgió en los años cincuenta, cuando los científicos querían recaudar dinero para sus investigaciones. Pensaron que sonaba a algo que el Estado fomentaría de buen grado. Y ahora pendemos de este nombre. La mayoría de los científicos informáticos lo encuentran inapropiado[3].

Machine learning o deep learning son denominaciones igualmente confusas, especialmente si hemos de entender que es la propia máquina la que aprende.

Todas estas denominaciones –señuelos, habría que decir- tienen una función comercial, publicitaria, incluso propagandística, pero no responden a la verdad de la cosa. Inmediatamente entran en resonancia con la ciencia ficción y con los titulares de los medios. Y así, ensoñaciones y terrores futuroscópicos comienzan a medrar. Pero ninguna máquina entiende, ni conoce, ni aprende, ni cuenta hasta dos siquiera. Sí las personas, con ayuda, a veces, de las máquinas.

Otros términos más ajustados

Por ello se han propuesto otros términos, como inteligencia asistida, inteligencia ampliada, inteligencia artificial centrada en humanos, o bien, como ha sugerido Sara Lumbreras, de la Universidad de Comillas, herramientas de apoyo a la decisión. Son nombres más apropiados, pues indican que el sujeto inteligente es una persona, mientras que la máquina puede asistir o ampliar la inteligencia de dicho sujeto. También podríamos hablar, y creo que sería lo más ajustado, de sistemas de control delegado (CoDe).

El cambio de perspectiva que necesitamos podría resumirse en pocas palabras: hay que pasar de considerar los sistemas de IA como «sistemas técnicos con consecuencias sociales» a considerarlos como «sistemas sociales técnicamente implementados»[4]. O sea, las personas también forman parte de los sistemas de IA, como diseñadores, mantenedores, usuarios, supervisores… Es en estas personas, y no en la parte artificial, en las que reside la inteligencia de estos sistemas. Las máquinas no pueden ser inteligentes. Esta limitación no responde a un problema técnico que pueda ser subsanado, sino a una cuestión ontológica.

Pero, ¿qué es la inteligencia?

Capacidad de entender o comprender

Podemos acudir a las acepciones pertinentes del DRAE:

Capacidad de entender o comprender […] Capacidad de resolver problemas.

Sabemos que la parte artificial de un sistema IA es incapaz por sí sola de entender o de comprender. Ni siquiera se puede decir con propiedad que una máquina cuente o compute. Contar implica reunir dos (o más) momentos, y mantenerlos como tales, en una sola e idéntica representación consciente, entendiendo al mismo tiempo la semejanza y la diferencia entre ambos[5], cosa que una máquina no hace. Sí es cierto, en cambio, que la IA puede ayudarnos a resolver múltiples problemas (cómputo, geolocalización, logística, asistencia telefónica, asistencia al diagnóstico médico, a la publicidad y un largo etcétera). Pero estos problemas no lo son para la parte artificial del sistema, sino para el diseñador o para el usuario del mismo.

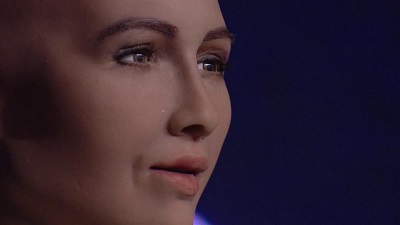

Para una máquina de reconocimiento facial, el reconocer o no a un delincuente no supone un problema. Es un problema para la seguridad de las personas, y el sistema puede ayudarnos a afrontarlo. Por supuesto, el mismo sistema puede servir para controlar a la población de un país y para facilitar allí la represión política. Pero esto tampoco es un problema para las cámaras o para el software implicado. Lo es, indudablemente, para los sufridos súbditos del país en cuestión. Solo un ser vivo puede sufrir y morir, solo una persona puede preguntarse por el sentido de su vida. Esos son problemas. Y tanto un martillo o un ábaco como una red informática, cada uno a su modo, puede ayudarnos a afrontarlos (o a empeorarlos). Pero esto no los convierte en inteligentes.

Capacidad de simulación

Podemos verlo aun desde otro ángulo. A veces se caracteriza la llamada IA por su capacidad de simulación. Simula funciones propias de la inteligencia humana, se dice. Pero simular la inteligencia no es lo mismo que ser inteligente. La simulación, además, consta solo como tal para el ser humano que la observa, no para la máquina. Por otro lado, la propia noción de función remite inexorablemente a la de un ser para la cual un efecto dado es funcional. Fuera del marco humano, las luces que se encienden en una pantalla o los movimientos de un robot son meros efectos, no cumplen funciones. Es el punto de vista humano el que cambia su ontología.

It’s the ontology, stupid

Su ontología viene definida por su función

Porque la cuestión es en el fondo –insistamos- de carácter ontológico. Los artefactos, en la tradición aristotélica, son sustancias solo en un sentido accidental, por analogía. Los seres vivos, y en especial los seres humanos, es decir, las personas, sí son sustancias en sentido propio y paradigmático. Al tratarse de una diferencia ontológica, la esperanza (o la amenaza) de anularla por la vía de la sofisticación tecnológica resulta ilusoria, un mero error categorial.

Lo dicho hasta aquí afecta a cualquier sistema tecnológico (de lavado, de transporte, de producción de energía, de comunicación…). Todos ellos, si se colocan al margen de lo humano pierden la funcionalidad, pasan a ser meros sistemas de efectos físicos. Como quiera que su ontología viene dada por su función, pierden también su rango ontológico, dejan de ser lo que eran. Una lavadora en Neptuno no es ya una lavadora. Pero la ontología de los sistemas llamados de IA depende aun más intensamente de la mirada humana, pues se sitúan en el ámbito de lo intencional, es decir, de lo semiótico. En este ámbito las entidades se sostienen sobre tres apoyos. Si retiramos uno de ellos se vienen abajo, como les pasa a los taburetes. Charles S. Peirce lo expone con claridad:

All dynamical action, or action of brute force […] takes place between two subjects […] But by semiosis I mean, on the contrary, an action or influence which is or involves a cooperation of three subjects, such as a sign, its object and its interpretant, this three-relative influence not being in any way resolvable into actions between pairs[6].

La persona (inteligente) es quien introduce la relación semiótica

¿Qué queremos decir cuando afirmamos que una máquina almacena o procesa mis datos financieros o médicos? Decimos que cierto estado electromagnético de la máquina (sign) se relaciona con mi nómina o con mi tensión arterial (object). Obviamente no hay entre ellos una relación física, sino una relación semiótica que se establece a través de una persona (interpretant) capaz de entender –con la ayuda de ciertos interfaces- estados electromagnéticos como ingresos o como presión sanguínea.

Análogamente, la máquina solo juega ajedrez o go si una persona puede relacionar los estados físicos de la misma con estos juegos tradicionalmente ejecutados por humanos. El caso del ajedrez es muy ilustrativo: cuando una máquina cumple por fin ciertas expectativas, queda al mismo tiempo privada del aura mitológica que la envolvía cuando era tan solo un proyecto, queda rebajada al nivel de lo prosaico, desprovista de fantasma y de glamour. Ahí está Deep Blue, que conoció días de gloria, criando polvo de museo. Y todos nos hemos enterado, por fin, de que un robot ajedrecista es aproximadamente tan interesante como un robot aspirador. Sin interpretant, la máquina solo cambia de un estado físico a otro. Ya no es parte de un sistema de IA. Es solo un trozo de materia, como una lavadora en Neptuno. ¿Por qué nos cuesta tanto asumirlo?

El efecto Toy Story

La mirada humana mantiene en el ser a lo artificial

Solemos imaginar, en cambio, que en nuestra ausencia los artefactos siguen teniendo la misma entidad que en nuestra presencia. Así, imaginamos que una máquina que forma parte de un sistema de IA, junto con ciertas personas, sigue siendo inteligente aunque prescindamos de la mirada de esas personas. Pero este espejismo no se debe a un exceso, sino a una falta de imaginación. No es fácil imaginar cómo se ve el mundo cuando el mundo no es visto por nadie. Antonio Machado escribió estos versos:

Dijo Dios: Brote la nada. / Y alzó la mano derecha, / hasta ocultar su mirada. / Y quedó la nada hecha.

O bien, reinterpretando a Cervantes:

Fuese, y no hubo nada.

La mirada de Dios sostiene al mundo en el ser. La del ser humano sostiene el ser de lo artificial. Sin la mirada de Dios todo es aniquilado. Sin la mirada de una persona humana, lo artificial no pasa a la nada, pues nuestro poder no es tanto, pero sí se aplana, queda en pura realidad física.

De ahí la dificultad de imaginar. Es más fácil soñar que todo sigue igual cuando dejo de mirar. Es lo que podríamos llamar efecto Toy Story. La mano y el ojo del niño convierten un pedazo de plástico verde en un dinosaurio tímido. El niño imagina que cuando él sale de la habitación, el dinosaurio sigue ahí. No es capaz de pensarlo como el pedazo de plástico verde que es una vez que el propio niño deja el cuarto de juegos o se duerme. No puede imaginarlo porque cuando despierta, el dinosaurio todavía está ahí.

¿Qué sería de las máquinas sin el ser humano?

¿Qué imaginamos que sucedería si el ser humano saliese de la habitación (¿china?), si quedase al margen de los sistemas de IA? Para algunos, esto ocurrirá a partir del punto que llaman singularidad. Desde ahí las máquinas generarían otras máquinas más listas, un mundo post-humano controlado por robots.

Pero quizá podríamos imaginar, por el contrario, que las máquinas dejadas a sí mismas pronto sufrirían fallos en virtud de la tendencia general a la entropía, de los defectos de diseño y construcción, así como de la dificultad para obtener energía estable; decaerían y se verían re-incorporadas a los procesos naturales de tipo físico (como la erosión) y químico (como la oxidación). Incluso de tipo biológico: el paisaje post-humano más probable no es el de la Tierra gobernada por robots inteligentes, sino el de una frondosa jungla que esconde en sus entrañas, junto con las piedras de antiguos templos, auténticas cochambres de silicio, plástico y metal. De hecho, toda máquina ha de ser man-tenida, o sea, llevada de la mano por las personas. Todo sistema de IA requiere mantenimiento. Y los más sofisticados requieren más mantenimiento, no menos.

Sin inteligencia humana, la inteligencia artificial deja de ser inteligente

En suma, los datos son datos acerca de algo, la inteligencia lo es de algo, la información lo es sobre algo. Son entidades de la terceridad, semióticas, intencionales. El estado electromagnético (o cuántico) de un computador no es de por sí un dato, a menos que un interpretante lo conecte con un objeto. Y la dependencia de los datos respecto de una conciencia que los convierta en tales resulta extrema en el caso de los llamados datos sintéticos, cuya relación con la verdad es tan difícil de establecer.

Sin personas, un sistema de IA deja inmediatamente de ser inteligente. Ya no hay datos. Ya no entiende nada. Ya no simula nada. Ya no cumple función alguna. Sus problemas se han acabado al fin. Lo que llamábamos información se diluye. Toda decisión deja de serlo. Añadamos que no hay realidad virtual, sino representación digital de la realidad, de la única realidad que existe, dentro de la cual lo virtual tiene cabida como representación, pero decae cuando no hay nadie ante quien representar algo. En este sentido -coincido con Luc Julia-, la IA no existe. Es el mero efecto de una pobre imaginación metafísica, puesta al servicio a veces de la ambición pecuniaria o política.

A fin de evitar equívocos, deberíamos cambiar “IA” por un nombre menos torticero, pues La perturbación que genera un mal nombre acaba por proyectarse sobre la propia antropología. Así, la inteligencia humana es degradada o reducida a un juego de interacciones físicas, y el propio ser humano pasa a ser comprendido en términos dualistas, como una suerte de lugar de encuentro fortuito entre un hardware corporal y un software mental susceptible de migración.

Una inteligencia prudencial

A la hora de enfrentarnos a fenómeno complejos, tenemos que echar mano, sí, de la fuerza bruta de computación, pero también de toda la imaginación, creatividad, intuición y prudencia de que sea capaz el ser humano. De hecho, el “método” más abarcador, el que regula la aplicación de todos los demás, incluidos los automatizables, es la prudencia[7].

Por lo que sabemos, el universo no es una suerte de reloj eterno, sino un acontecimiento único, histórico y contingente. Está dotado de un cierto entramado de regularidades, suficiente para posibilitar la vida y la intelección, pero compensado con novedades impredecibles. Esta distribución tan peculiar de la constancia y la ruptura afecta tanto al discurrir de los astros, como a nuestra vida cotidiana, hecha de ciclos imperfectos, de ritmos circadianos, de costumbre y sobresalto. Solo una inteligencia viva, sentiente, situada, una inteligencia prudencial como la humana, puede entenderse con esta desconcertante textura del universo. Aprendemos de la experiencia, pero sabemos a un tiempo que no hay ninguna garantía de que las cosas sigan siendo como venían siendo. De ahí la conveniencia de la humildad intelectual, que se ha vestido a lo largo del tiempo de actitud socrática, de prudencia aristotélica, de docta ignorancia, de falibilismo.

La inteligencia artificial no tiene prudencia por sí misma

Un sistema de IA genera unas expectativas. Coloca un punto en un espacio n-dimensional construido a partir de un histórico de datos, y, en función de ello, nos dice qué se puede esperar del objeto representado por ese punto. Pero el sistema puede colapsar cuando registra la ocurrencia de algo cuya posibilidad ni siquiera era considerada. Cuando esto ocurre, el propio sistema se queda sin capacidad de adaptación, no puede aprender de esta experiencia. Cuando esto sucede, no son los algoritmos los que deben reaccionar, sino las personas responsables de los mismos. Y reaccionarán, en primer lugar, cambiando drásticamente las expectativas.

Lo pueden hacer dado que no son artefactos, sino personas conscientes que pueden llegar a entender el fenómeno, cosa que no se espera de la máquina, y que pueden poner en marcha su creatividad para generar en adelante mejores expectativas con o sin ayuda mecánica. Y este paso no tiene por qué ser puramente arbitrario, azaroso o irracional, sino que, en algún sentido, está guiado por un saber práctico y social que Aristóteles llamó phrónesis, prudencia. Dicho saber nos facilita la constitución integradora de la experiencia, la gestión de las emociones vinculadas a la frustración de expectativas, la propedéutica del momento creativo y el filtrado crítico de los sistemas de expectativas emergentes.

En consecuencia, un sistema de IA que pretenda sustituir a la prudencia humana simplemente estaría fuera de lugar, fuera del universo que nos alberga. Por el contrario, un sistema CoDe inscrito en el marco de una inteligencia humana prudencial estará en el lugar que le corresponde y podrá cumplir funciones de gran valor para la vida humana.

Y algunas conclusiones prácticas

Poner a la inteligencia artificial en el marco de la vida humana

La nueva denominación (CoDe) hace justicia a la verdadera ontología de estos sistemas y, sobre todo, nos lleva de modo más directo a las cuestiones prácticas importantes. Empezamos a ver cuál ha de ser la posición relativa del ser humano y de las máquinas. No se trata de deformar al primero para que encaje en un mundo presuntamente dominado por inteligencias mecánicas, sino de poner las segundas en el marco de la vida humana, fuera del cual dejan de funcionar, dejan incluso de ser. ¿Qué pueden aportar a la vida humana los algoritmos? Nos permiten delegar ciertos procesos de control.

Pensar quién y qué se delega en las máquinas

Ahora podemos plantear con más propiedad las cuestiones prácticas pertinentes, de tipo ético, político, educativo, legal… ¿Quién delega?, ¿está legitimado para hacerlo? ¿En qué sistemas CoDe delega?, ¿son los más apropiados? ¿Qué tipo de acciones son delegadas?, ¿resultan, de verdad, delegables? ¿Por cuánto tiempo se cede el control?, ¿es sensato? ¿Es reversible la delegación? ¿Qué procedimientos de supervisión o evaluación existen?, ¿son suficientes? ¿Qué riesgos se asumen en caso de fallo?, ¿es prudente asumirlos? ¿Qué ventajas se obtienen para la vida humana con la delegación de control?, ¿qué se pierde a cambio?…

Los problemas prácticos no tienen que ver con un supuesto futuro post-humano de máquinas inteligentes.

Lo que debería aterrorizarnos –asegura Ramón López de Mántaras, fundador del Instituto de Investigación en IA del CSIC- no es un futuro dominado por una hipotética IA superior […] Lo que realmente debería preocuparnos es la situación presente, en la que estamos delegando cada vez más tareas en una IA tan limitada como la actual[8].

Lo crucial tiene que ver con el presente, con el modo en que se están empleando ya los sistemas de CoDe, con la responsabilidad que sobre ello tienen ciertas personas, empresas y gobiernos, así como con el impacto que este empleo tiene ya sobre la vida de todos nosotros.

Educar a las personas en la virtud

En el plano educativo, es, desde luego, imprescindible formar en la virtud a las personas, más que instruir a las máquinas en la ideología de lo políticamente correcto. Los sesgos injustos no serán reconducidos mediante el rediseño de algoritmos, sino mediante el desarrollo de personas virtuosas. Y las virtudes han de ser educadas en el contexto tecnológico actual. Por ejemplo, mediante prácticas de silencio tecnológico[9].

Identificar déficit de legitimidad y riesgos para la libertad personal

En el plano político, el enfoque de CoDe nos permite identificar inmediatamente el déficit de legitimidad y el riesgo para la libertad de las personas. Así, la mayor parte de la las tecnologías CoDe están en manos, en última instancia, del Partido Comunista Chino o de unas pocas grandes corporaciones norteamericanas. Europa se ha quedado al margen. Los grandes de la llamada IA son, del lado occidental, los GAFAM (Google, Amazon, Facebook, Appel y Microsoft) y, del lado chino, los BATX (Baidu, Alibaba, Tencent, Xiaomi). La primera impresión que obtenemos es que hay demasiado poder en muy pocas manos.

El caso de China, respaldado por Unicef

Hemos de preguntarnos si es legítimo el poder que detentan. Si no lo es, tampoco lo será que lo deleguen en los algoritmos. Se entiende que el sometido pueblo chino oriente su protesta hacia los algoritmos, y no directamente hacia el Partido Comunista[10]. Lo que no se entiende es que Unicef esté respaldando el uso liberticida de los algoritmos: «los principios chinos [Academia de Inteligencia Artificial de Pekín] –afirma Karen Hao- están estrechamente alineados con las recomendaciones de Unicef” respecto al impacto de la IA sobre los niños[11]. El PCCh, que siempre ha sido una desgracia para el pueblo chino, constituye, ahora, con la llamada IA en sus manos, una amenaza para la humanidad entera. En vista de ello, tanto Unicef como Unesco deberían reconsiderar lo que están haciendo –¡y dejando de hacer!- al respecto.

Estados Unidos

Y algo análogo cabe decir respecto a las grandes corporaciones norteamericanas que controlan el resto del pastel de la llamada IA. Es perentorio, por la salud de las democracias y por la libertad de las personas, que el poder desmedido de dichas corporaciones sea disuelto. Un consumo digital responsable, un uso lúcido de las redes sociales y una gestión prudencial de los datos propios resultarían ya de ayuda. Pero además sería pertinente la presión política y de la opinión pública a favor de la disolución de núcleos de poder abusivo.

Con lo dicho no deseo ni siquiera insinuar que haya simetría entre el caso chino y el americano. En el primero, el uso de sistemas CoDe para el sometimiento de la población debería ser simplemente combatido por Europa. En el segundo, bastaría con apoyar acciones a favor de un fraccionamiento de las corporaciones GAFAM.

Los derechos digitales

Dentro de las cuestiones prácticas quiero referirme, por último, a los presuntos derechos digitales. Debería estar claro ya a estas alturas que los robots no tienen derechos, ni son responsables de nada, ni han de pagar impuestos, que es absurdo hablar de los derechos del software. Estamos, de nuevo, ante un error categorial. Pero tampoco me parece muy perspicaz ni muy útil solicitar para los seres humanos una cuarta generación de derechos, esta vez –digamos, por resumir- digitales. Inventar derechos humanos nuevos debilita la propia idea misma de “derechos humanos”. Los derechos humanos se basan en la dignidad de la persona y en su pertenencia a la familia humana. Es siempre tentador emplear esta fórmula –“derechos humanos”- para proteger cualquier bien tenido por valioso. Pero, en la medida en que se amplía el campo al cual se aplica, inexorablemente merma la fuerza protectora de la misma.

Si entendemos por derechos humanos los de la primera generación, fundamentalmente el derecho a la vida y a la libertad, entonces la acusación de haber violado los derechos humanos es una acusación de enorme gravedad. Pero si incluimos no solo los derechos de segunda y tercera generación, sino también los nuevos derechos digitales y los neuroderechos, más los derechos “humanos” de los robots o de los animales, entonces la acusación de violación de un derecho se vuelve apenas turbadora. Mucho más perspicaz y útil sería conectar lo digital con los derechos humanos básicos, mostrar cómo afecta a los mismos, sin inventar nuevas listas de supuestos derechos. Lo grave de algunos sistemas CoDe no es que violen nuestros presuntos derechos digitales, es que amenazan nuestra vida o comprometen nuestra libertad.

En resumen…

La IA no existe. Sin la mirada humana cualquier artefacto pierde su aspecto intencional y colapsa en simple sistema físico. Existen sistemas de IA, de los cuales forman parte las personas. Lo que tienen de inteligente no es artificial y lo que tienen de artificial no es inteligente[12]. El nombre, por lo tanto, es desorientador. Sería más acertado hablar de sistemas CoDe.

Los sistemas CoDe ya están aportando ventajas y causando problemas hoy. No es pertinente discutir sus aspectos prácticos mirando a un lejano futuro post-humano, sino al presente de nuestras vidas. La mayor parte de la llamada IA depende del PCCh y de unas pocas corporaciones norteamericanas. El control que estos polos de poder ejercen sobre nuestras vidas a través de sistemas CoDe es totalitario en el primer caso, abusivo en el segundo. Aun así, no es adecuada la promoción de nuevos derechos ad hoc. La protección frente a este control ha de derivar de la educación en virtudes (prudencia, serenidad, creatividad, laboriosidad…) y del respeto a los derechos humanos fundamentales.

NOTAS

[1] Éditions First, París, 2019.

[2] Harvard University Press, 2021.

[3] Anna Von Hopffgarten entrevista a Katharina Zweig, “La inteligencia artificial carece de la flexibilidad de decisión humana”, Mente y Cerebro, enero/febrero, 2021.

[4] R. Hirschheim, H. K. Klein y K. Lyytinen, Information Systems Development and Data Modelling, CUP, 1995, p. 1.

[5]A. Marcos, “La relación de semejanza como principio de inteligibilidad de la naturaleza”, en F. Rodríguez Valls (ed.), La inteligencia en la naturaleza, Biblioteca Nueva, Madrid, 2012, pp. 73-94.

[6] Charles S. Peirce, Collected Papers, Harvard University Press, Cambridge (MA), vol. 5. p. 484, 1931-1935.

[7] “Código de conducta articulado en torno a seis puntos: [1] Prudencia”, Declaración de Barcelona para el desarrollo y uso adecuado de la IA en Europa, 2017.

[8] “El traje nuevo de la IA”, Investigación y Ciencia, 526: 50-59, julio, 2020, p.59.

[9] A. Marcos, “Silencio tecnológico”, Scio, 15: 157-176, 2018.

[10] Christina Larson, “La tecnogobernanza china: ¿quién necesita democracia si tiene datos?”, MIT Technology Review, 31 Agosto, 2018.

[11] Karen Hao, “El mundo empieza a sentir la urgencia de proteger a los niños de la IA”, MIT Technology Review, 25 Septiembre, 2020.

[12] A. Marcos, “Información e Inteligencia Artificial”, Apeiron, 12: 73-82, 2020.

REPOSITORIO DE IMÁGENES DE LA INTELIGENCIA ARTIFICIAL Y EL EFECTO TOY STORY

Imagen 1: https://livre.fnac.com/a12970716/Luc-Julia-L-intelligence-artificielle-n-existe-pas

Imagen 2: https://ayudaleyprotecciondatos.es/2019/03/22/reconocimiento-facial/

Imagen 3: https://www.elperiodico.com/es/sociedad/20160219/deep-blue-contra-kasparov-el-primer-duelo-del-siglo-4906200

Imagen 4: https://www.hipercor.es/juguetes/A30352288-disney-toy-story-4-figura-basica-de-rex/

Imagen 5: https://www.ticbeat.com/tecnologias/sofia-el-robot-humanoide-que-interactua-con-las-personas-y-siente-emociones/

Imagen 6 (e inicial): https://www.apd.es/tipos-de-inteligencia-artificial/

Otro artículo de Alfredo Marcos publicado en esta web: Presente y futuro de la naturaleza humana

About the author

Alfredo Marcos

Catedrático de Lógica y Filosofía de la Ciencia de la Universidad de Valladolid.

El estudio aplica con lúcido tino a la etapa previa al 2022. En los tres años siguientes se esta produciendo la mayor escalada tecnológica de los últimos siglos. Entramos al paradigma agentico, que abre un espacio diferente al de la IA tradicional . El de la autonomía de los agentes oganizacionales. Estimo que hay reflexiones en la obra que merecen una reconsideración